什么是注意力机制?一文解析其原理与应用

AI 大模型 LLM

注意力机制:AI的焦点聚焦术

在深度学习的世界中,注意力机制(Attention Mechanism)以其独特的功能吸引了众多研究者的目光。这一技术源于对人类视觉注意力的模仿,**旨在使模型能够在处理输入数据时,像人类一样识别并集中关注其中最为关键的部分。**在图像识别、语音处理和自然语言理解等众多任务中,注意力机制的作用不可小觑,它不仅提高了模型的处理效率,还增强了对关键信息的关注度,从而显著提升了整体性能。

注意力机制的核心在于,它能够使模型在处理过程中动态地调整对输入数据不同部分的关注程度。这种能力特别适用于那些需要从大量信息中迅速筛选出关键信息的场景。例如,在自然语言处理中,注意力机制可以帮助模型在理解一句话时,重点分析与当前上下文最相关的词汇,而在图像识别中,它能够让模型专注于图像中可能包含对象的关键区域。

Encoder-Decoder框架:AI处理数据的新范式

在深度学习的众多模型中,无论是卷积神经网络(CNN)、循环神经网络(RNN)、长-短时记忆网络(LSTM)还是自动编码器(AE),它们都可以被归入到一个统一的框架——Encoder-Decoder框架中。这一框架的基本思想是将输入数据通过一个Encoder(编码器)进行转换,得到一个编码表示,然后再由Decoder(解码器)根据这个编码表示生成输出。

Encoder-Decoder框架的强大之处在于,它能够处理输入和输出在形式上可能大不相同的问题。例如,在机器翻译任务中,输入是一个英文句子,输出则是对应的中文句子。通过Encoder,模型能够捕捉到英文句子中的关键信息,并将其转化为一种内部表示,接着Decoder则使用这种表示来生成目标语言的句子。这个过程中,注意力机制发挥着重要作用,它帮助模型在生成目标语言的每个词时,都能够准确地关注到源语言句子中的相关信息。

Self Attention模型:内部信息的精准对齐

在深度学习的领域中,有一种特殊的注意力机制——Self Attention模型,它打破了传统注意力机制在输入Source和输出Target之间建立联系的局限,转而关注Source内部元素之间或者Target内部元素之间的关系。这种模型也被称为intra Attention(内部注意力),其核心思想在于探索数据内部元素之间的相互依赖性。

以机器翻译为例,传统的注意力机制关注的是目标语单词和源语单词之间的对齐关系,而Self Attention模型则是在源语句子内部或目标语句子内部建立注意力连接。这意味着,在翻译一个单词时,模型不仅会考虑源语中与之直接对应的词,还会考虑上下文中其他可能与其相关的词。同样,在图像处理中,Self Attention模型能够使模型在生成图像某一部分的描述时,考虑到图像其他部分的信息。

计算过程上,Self Attention模型与常规的注意力机制是类似的。它通过计算每个元素与其他所有元素之间的相关性来生成注意力权重,然后根据这些权重对元素进行加权求和。唯一的区别在于,计算相关性的对象从Source和Target之间的元素转变为Source或Target内部的元素。这种变化使得模型能够捕捉到数据内部更细微的关联,从而提高整体处理的效果。

图片描述中的注意力机制:从视觉到语言的精准映射

注意力机制在实际应用中展现出了强大的能力,特别是在图片描述(Image-Caption)任务中,其作用尤为显著。这一任务要求AI应用系统根据输入的图片生成一句或多句描述性文本,不仅需要准确捕捉图片中的关键信息,还要确保生成的文本语义丰富且通顺。

在这个任务中,Encoder-Decoder框架起到了关键作用。Encoder阶段通常由一个卷积神经网络(CNN)组成,负责提取图片中的视觉特征。Decoder阶段则由一个循环神经网络(RNN)或其变体,如LSTM承担,用于生成语言描述。注意力机制的引入,使得模型在生成每个单词时,都能够聚焦于图片中与其语义最相关的区域。

具体来说,当模型在输出某个实体单词时,比如“person”或“surfboard”,注意力机制会引导模型关注图片中相应的区域,从而确保描述的准确性和针对性。例如,在生成句子“A person is standing on a beach with a surfboard.”时,模型在生成“person”一词时会重点关注图片中的人物,而在生成“surfboard”时则会聚焦在冲浪板上。这种注意力聚焦区域的可视化不仅揭示了模型的决策过程,也证明了注意力机制在提高模型性能方面的有效性。

注意力机制:开启多领域智能应用的新篇章

注意力机制自2014年提出以来,已经成为了深度学习领域的一个热点研究方向。在短短几年间,它已经被成功应用于机器翻译、图像处理、语音识别、智能客服等多个领域,并在这些领域中取得了令人瞩目的成果。例如,在自然语言处理中,基于注意力机制的模型已经在多个语言理解任务上超越了之前的最佳成绩,显示了注意力机制在处理序列数据时的优越性。

随着研究的深入,注意力机制的应用范围也在不断扩大。未来,它有望被应用于更多领域,如医疗诊断、自动驾驶和金融分析等。在医疗领域,注意力机制可以帮助模型从大量的患者数据中识别出关键信息,以更准确地诊断疾病。在自动驾驶领域,它能够使模型更好地理解和预测交通环境中的复杂情况。而在金融分析中,注意力机制的应用则可能提高风险评估和投资决策的准确性。

随着硬件技术的进步和算法的不断优化,注意力机制的效率和效果都将得到进一步提升,从而在未来的各种智能系统中发挥更加关键的作用。这些潜在的应用不仅预示着注意力机制的广泛前景,也为研究人员提供了新的研究方向和挑战。

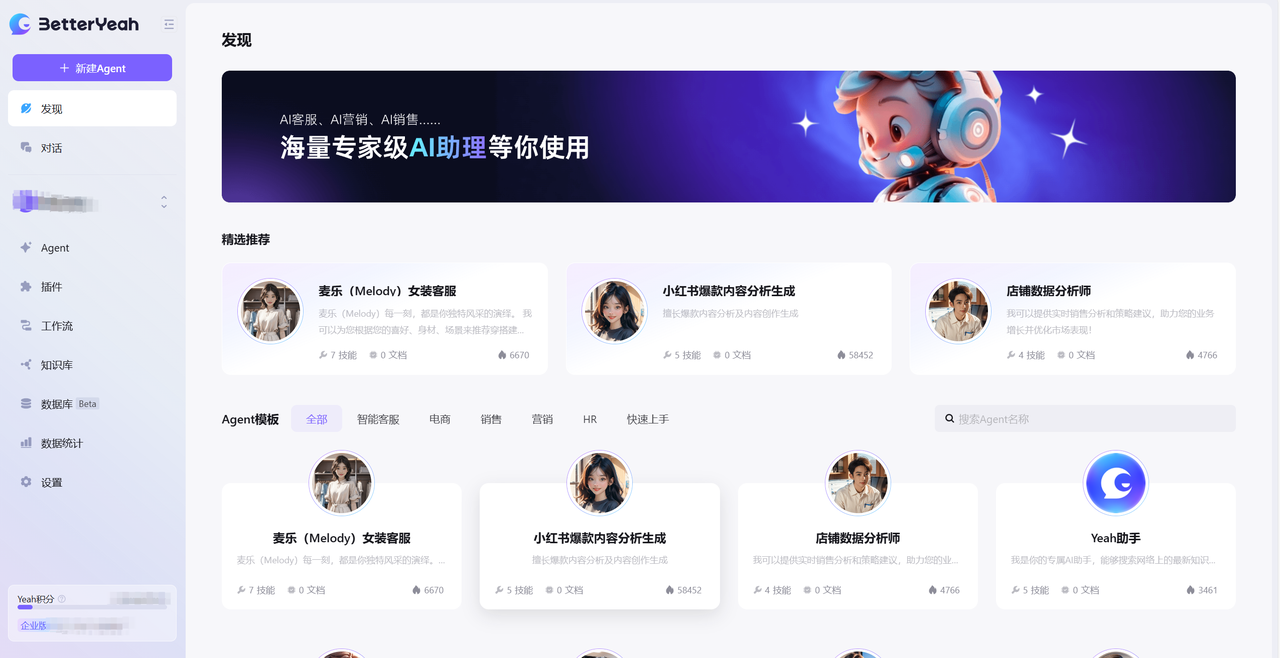

BetterYeah AI Agent如何提供帮助?

BetterYeah AI Agent作为国内领先的企业级智能体开发平台,为企业AI大模型应用落地提供了全面的支持。平台强调“零代码搭建Agent”的理念,通过直观的图形化界面,使用户无需任何编程知识即可快速搭建和部署功能强大的智能体Agent,有效释放大型AI模型的潜力,应对各种复杂的业务需求。

BetterYeah AI Agent的一站式模型集成功能极大地丰富了用户的选择,内置有多种国内外知名AI模型如ChatGLM、阿里通义千问、百度千帆等,用户可以根据不同的应用场景灵活选择最合适的模型,保证了系统的高性能和良好的适应性。

在知识管理方面,平台提供了自动向量化、自动分段和混合检索等高级数据处理工具,确保AI Agent能够基于本地知识库提供高质量且精准可控的输出。同时,通过与企业业务数据的深度集成,AI Agent不仅具备持久记忆,还能深入理解并适应企业的业务环境,提供更为个性化的服务。

为了提高业务流程的设计灵活性和效率,BetterYeah AI提供了易用的AI工作流能力,支持用户自定义和优化业务流程。平台还提供了丰富的官方插件,支持业务流程的快速扩展和多场景应用,极大地加速了AI Agent的部署和应用。

整合能力方面,AI Agent可以通过API、SDK和Webhook等方式轻松集成到现有系统中,与微信客服、钉钉、飞书等多种平台无缝对接。多模态智能问答功能支持处理和生成文字、图片、语音、视频等多种类型的内容,满足多样化的交互需求。

立即访问BetterYeah AI Agent官网,探索最新AI大模型应用案例,开启智能化转型之旅。